转自:https://blog.csdn.net/xuyankuanrong/article/details/77527381

命令格式

功能

FFmpeg命令是在ffmpeg.exe可执行文件环境下执行,ffmpeg.exe用于音视频的转码,加水印,去水印,视频剪切,提取音频,提取视频,码率控制等等功能。

最简单的命令

ffmpeg -i input.avi -b:v 640k output.mp4

该命令将当前文件夹下的input.avi文件转换为output.mp4文件,并将output.mp4文件视频的码率设置为640kpbs。

命令格式

ffmpeg -i {输入文件路径} -b:v {输出视频码率} {输出文件路径}

所有的参数都是以键值对的形式指定的。例如输入文件参数是”-i”,而参数值是文件路径;输出视频码率参数是”-b:v”,而参数值时视频的码率值。但是注意位于最后面的输出文件路径前面不包含参数名称。

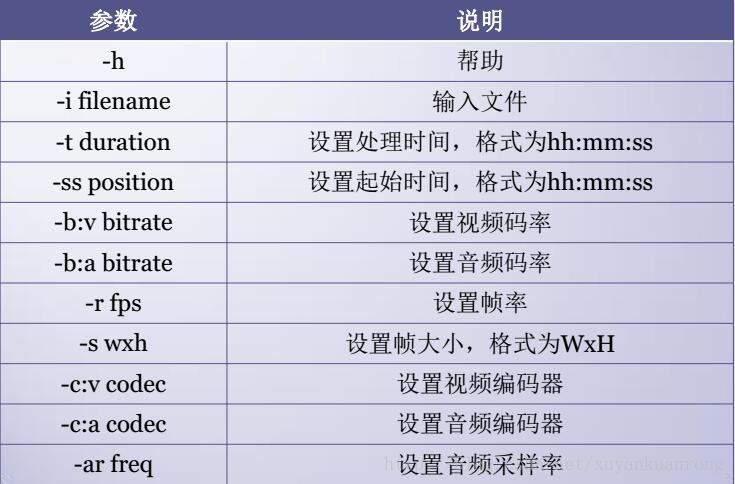

命令参数

//音频拼接

//方式一:

ffmpeg -i "concat:0.mp3|1.mp3" -acodec copy output.mp3

解释:-i代表输入参数

concat:0.mp3|1.mp3 需要连接到一起的音频文件

-acodec copy output.mp3 重新编码并复制到新文件中

//方式二:

-i 124.mp3 -i 123.mp3 -filter_complex amix=inputs=2:duration=first:dropout_transition=2 -f mp3 remix.mp3

//ffmpeg -i 0.mp3 -i 1.mp3 -i 2.mp3 -filter_complex '[0:0] [1:0] [2:0] concat=n=3:v=0:a=1 [a]' -map [a] meg1.mp3

解释:-i代表输入参数

-filter_complex ffmpeg滤镜功能,非常强大,详细请查看文档

amix是混合多个音频到单个音频输出

inputs=2代表是2个音频文件,如果更多则代表对应数字

duration 确定最终输出文件的长度

longest(最长)|shortest(最短)|first(第一个文件)

dropout_transition

The transition time, in seconds, for volume renormalization when an input stream ends. The default value is 2 seconds.

-f mp3 输出文件格式

方式三:

ffmpeg -f concat -i file.txt meg.mp3

解释:将需要拼接的音频文件名称写出 file 文件名.mp3换行,这样一行一行写到txt文件中,meg.mp3为输出文件。

//把darkdoor.[001-100].jpg序列帧和001.mp3音频文件利用mpeg4编码方式合成视频文件darkdoor.avi:

$ ffmpeg -i 001.mp3 -i darkdoor.%3d.jpg -s 1024x768 -author skypp -vcodec mpeg4 darkdoor.avi

//要查看你的ffmpeg支持哪些格式,可以用如下命令:

$ ffmpeg -formats | less

//还可以把视频文件导出成jpg序列帧:

$ ffmpeg -i bc-cinematic-en.avi example.%d.jpg

//debian下安装ffmpeg很简单:

#apt-get install ffmpeg

#音频转码

转MP3为wav

ffmpeg -i input.mp3 -acodec pcm_s16le -ac 2 -ar 44100 output.wav

转m4a为wav

ffmpeg -iinput.m4a -acodec pcm_s16le -ac 2 -ar 44100 output.wav

wav与PCM的相互转换,把raw改为pcm即可

ffmpeg -iinput.wav -f s16le -ar 44100 -acodec pcm_s16le output.raw

PCM转wav

ffmpeg -f s16le -ar 44100 -ac 2 -acodec pcm_s16le -i input.raw output.wav

用ffplay播放PCM

ffplay -f s16le -ar 44100 -ac 2 **.raw

//提取音频

ffmpeg -i test.mp4 -acodec copy -vn output.aac

//上面的命令,默认mp4的audio codec是aac,如果不是,可以都转为最常见的aac。

ffmpeg -i test.mp4 -acodec aac -vn output.aac

//提取视频

ffmpeg -i input.mp4 -vcodec copy -an output.mp4

//视频剪切

//下面的命令,可以从时间为00:00:15开始,截取5秒钟的视频。

ffmpeg -ss 00:00:15 -t 00:00:05 -i input.mp4 -vcodec copy -acodec copy output.mp4

//-ss表示开始切割的时间,-t表示要切多少。上面就是从15秒开始,切5秒钟出来。

//码率控制

//码率控制对于在线视频比较重要。因为在线视频需要考虑其能提供的带宽。

//那么,什么是码率?很简单:

//bitrate = file size / duration

//比如一个文件20.8M,时长1分钟,那么,码率就是:

//biterate = 20.8M bit/60s = 20.8*1024*1024*8 bit/60s= 2831Kbps

//一般音频的码率只有固定几种,比如是128Kbps,

//那么,video的就是

//video biterate = 2831Kbps -128Kbps = 2703Kbps。

//那么ffmpeg如何控制码率。

//ffmpg控制码率有3种选择,-minrate -b:v -maxrate

//-b:v主要是控制平均码率。

//比如一个视频源的码率太高了,有10Mbps,文件太大,想把文件弄小一点,但是又不破坏分辨率。

ffmpeg -i input.mp4 -b:v 2000k output.mp4

//上面把码率从原码率转成2Mbps码率,这样其实也间接让文件变小了。目测接近一半。

//不过,ffmpeg官方wiki比较建议,设置b:v时,同时加上 -bufsize

//-bufsize 用于设置码率控制缓冲器的大小,设置的好处是,让整体的码率更趋近于希望的值,减少波动。(简单来说,比如1 2的平均值是1.5, 1.49 1.51 也是1.5, 当然是第二种比较好)

ffmpeg -i input.mp4 -b:v 2000k -bufsize 2000k output.mp4

//-minrate -maxrate就简单了,在线视频有时候,希望码率波动,不要超过一个阈值,可以设置maxrate。

ffmpeg -i input.mp4 -b:v 2000k -bufsize 2000k -maxrate 2500k output.mp4

//视频编码格式转换

//比如一个视频的编码是MPEG4,想用H264编码,咋办?

ffmpeg -i input.mp4 -vcodec h264 output.mp4

//相反也一样

ffmpeg -i input.mp4 -vcodec mpeg4 output.mp4

//当然了,如果ffmpeg当时编译时,添加了外部的x265或者X264,那也可以用外部的编码器来编码。(不知道什么是X265,可以 Google一下,简单的说,就是她不包含在ffmpeg的源码里,是独立的一个开源代码,用于编码HEVC,ffmpeg编码时可以调用它。当然 了,ffmpeg自己也有编码器)

ffmpeg -i input.mp4 -c:v libx265 output.mp4

ffmpeg -i input.mp4 -c:v libx264 output.mp4

//只提取视频ES数据

ffmpeg –i input.mp4 –vcodec copy –an –f m4v output.h264

//过滤器的使用

//将输入的1920x1080缩小到960x540输出:

ffmpeg -i input.mp4 -vf scale=960:540 output.mp4

//ps: 如果540不写,写成-1,即scale=960:-1, 那也是可以的,ffmpeg会通知缩放滤镜在输出时保持原始的宽高比。

//为视频添加logo(也就是为视频添加水印)

//将一张图片贴到一个视频上,那可以用如下命令:

ffmpeg -i input.mp4 -i iQIYI_logo.png -filter_complex overlay output.mp4

要贴到其他地方?看下面:

//右上角:

ffmpeg -i input.mp4 -i logo.png -filter_complex overlay=W-w output.mp4

//左下角:

ffmpeg -i input.mp4 -i logo.png -filter_complex overlay=0:H-h output.mp4

//右下角:

ffmpeg -i input.mp4 -i logo.png -filter_complex overlay=W-w:H-h output.mp4

//可以设置坐标,视频的左上角为原点

ffmpeg -i input.mp4 -i logo.png -filter_complex overlay=480:10" output.mp4

//去掉视频的logo(去掉水印)

//语法:-vf delogo=x:y:w:h[:t[:show]]

//x:y 离左上角的坐标

//w:h logo的宽和高

//t: 矩形边缘的厚度默认值4

//show:若设置为1有一个绿色的矩形,默认值0。

ffmpeg -i input.mp4 -vf delogo=0:0:220:90:100:1 output.mp4

//截取视频图像

ffmpeg -i input.mp4 -r 1 -q:v 2 -f image2 pic-%03d.jpeg

//-r 表示每一秒几帧

//-q:v表示存储jpeg的图像质量,一般2是高质量。

//如此,ffmpeg会把input.mp4,每隔一秒,存一张图片下来。假设有60s,那会有60张。

//可以设置开始的时间,和你想要截取的时间。

ffmpeg -i input.mp4 -ss 00:00:20 -t 10 -r 1 -q:v 2 -f image2 pic-%03d.jpeg

//-ss 表示开始时间

//-t 表示共要多少时间。

//如此,ffmpeg会从input.mp4的第20s时间开始,往下10s,即20~30s这10秒钟之间,每隔1s就抓一帧,总共会抓10帧。

//序列帧与视频的相互转换

//把darkdoor.[001-100].jpg序列帧和001.mp3音频文件利用mpeg4编码方式合成视频文件darkdoor.avi:

$ ffmpeg -i 001.mp3 -i darkdoor.%3d.jpg -s 1024x768 -author fy -vcodec mpeg4 darkdoor.avi

//还可以把视频文件导出成jpg序列帧:

$ ffmpeg -i bc-cinematic-en.avi example.%d.jpg

//输出YUV420原始数据

//对于一下做底层编解码的人来说,有时候常要提取视频的YUV原始数据,如下:

ffmpeg -i input.mp4 output.yuv

//那如果我只想要抽取某一帧YUV呢?

//你先用上面的方法,先抽出jpeg图片,然后把jpeg转为YUV。

//比如:

//你先抽取10帧图片。

ffmpeg -i input.mp4 -ss 00:00:20 -t 10 -r 1 -q:v 2 -f image2 pic-%03d.jpeg

//然后,你就随便挑一张,转为YUV:

ffmpeg -i pic-001.jpeg -s 1440x1440 -pix_fmt yuv420p xxx3.yuv

//如果-s参数不写,则输出大小与输入一样。

//当然了,YUV还有yuv422p啥的,你在-pix_fmt 换成yuv422p就行啦!

//H264编码profile & level控制

//先科普一下profile&level。(这里讨论最常用的H264)

//H.264有四种画质级别,分别是baseline, extended, main, high:

// 1、Baseline Profile:基本画质。支持I/P 帧,只支持无交错(Progressive)和CAVLC;

// 2、Extended profile:进阶画质。支持I/P/B/SP/SI 帧,只支持无交错(Progressive)和CAVLC;(用的少)

// 3、Main profile:主流画质。提供I/P/B 帧,支持无交错(Progressive)和交错(Interlaced),

// 也支持CAVLC 和CABAC 的支持;

// 4、High profile:高级画质。在main Profile 的基础上增加了8x8内部预测、自定义量化、 无损视频编码和更多的YUV 格式;

//H.264 Baseline profile、Extended profile和Main profile都是针对8位样本数据、4:2:0格式(YUV)的视频序列。在相同配置情况下,High profile(HP)可以比Main profile(MP)降低10%的码率。

//根据应用领域的不同,Baseline profile多应用于实时通信领域,Main profile多应用于流媒体领域,High profile则多应用于广电和存储领域。

//fmpeg如何控制profile&level

ffmpeg -i input.mp4 -profile:v baseline -level 3.0 output.mp4

ffmpeg -i input.mp4 -profile:v main -level 4.2 output.mp4

ffmpeg -i input.mp4 -profile:v high -level 5.1 output.mp4

//如果ffmpeg编译时加了external的libx264,那就这么写:

ffmpeg -i input.mp4 -c:v libx264 -x264-params "profile=high:level=3.0" output.mp4

//从压缩比例来说,baseline< main < high,对于带宽比较局限的在线视频,可能会选择high,但有些时候,做个小视频,希望所有的设备基本都能解码(有些低端设备或早期的设备只能解码 baseline),那就牺牲文件大小吧,用baseline。自己取舍吧!

//编码效率和视频质量的取舍(preset, crf)

//除了上面提到的,强行配置biterate,或者强行配置profile/level,还有2个参数可以控制编码效率。

//一个是preset,一个是crf。

//preset也挺粗暴,基本原则就是,如果你觉得编码太快或太慢了,想改改,可以用profile。

//preset有如下参数可用:

//ultrafast, superfast, veryfast, faster, fast, medium, slow, slower, veryslow and placebo.

//编码加快,意味着信息丢失越严重,输出图像质量越差。

//CRF(Constant Rate Factor): 范围 0-51: 0是编码毫无丢失信息, 23 is 默认, 51 是最差的情况。相对合理的区间是18-28.

//值越大,压缩效率越高,但也意味着信息丢失越严重,输出图像质量越差。

//举个例子吧。

ffmpeg -i input -c:v libx264 -profile:v main -preset:v fast -level 3.1 -x264opts crf=18

//(参考自:[https://trac.ffmpeg.org/wiki/Encode/H.264]

//H265 (HEVC)编码tile&level控制

//和H264的profile&level一样,为了应对不同应用的需求,HEVC制定了“层级”(tier) 和“等级”(level)。

//tier只有main和high。

//不多说,直接给出怎么用。(supposed你用libx265编码)

ffmpeg -i input.mp4 -c:v libx265 -x265-params "profile=high:level=3.0" output.mp4

//a) 通用选项

-L license

-h 帮助

-fromats 显示可用的格式,编解码的,协议的。。。

-f fmt 强迫采用格式fmt

-I filename 输入文件

-y 覆盖输出文件

-t duration 设置纪录时间 hh:mm:ss[.xxx]格式的记录时间也支持

-ss position 搜索到指定的时间 [-]hh:mm:ss[.xxx]的格式也支持

-title string 设置标题

-author string 设置作者

-copyright string 设置版权

-comment string 设置评论

-target type 设置目标文件类型(vcd,svcd,dvd) 所有的格式选项(比特率,编解码以及缓冲区大小)自动设置 ,只需要输入如下的就可以了:

ffmpeg -i myfile.avi -target vcd /tmp/vcd.mpg

-hq 激活高质量设置

-itsoffset offset 设置以秒为基准的时间偏移,该选项影响所有后面的输入文件。该偏移被加到输入文件的时戳,定义一个正偏移意味着相应的流被延迟了 offset秒。 [-]hh:mm:ss[.xxx]的格式也支持

//b) 视频选项

-b bitrate 设置比特率,缺省200kb/s

-r fps 设置帧频 缺省25

-s size 设置帧大小 格式为WXH 缺省160X128.下面的简写也可以直接使用:

Sqcif 128X96 qcif 176X144 cif 252X288 4cif 704X576

-aspect aspect 设置横纵比 4:3 16:9 或 1.3333 1.7777

-croptop size 设置顶部切除带大小 像素单位

-cropbottom size –cropleft size –cropright size

-padtop size 设置顶部补齐的大小 像素单位

-padbottom size –padleft size –padright size –padcolor color 设置补齐条颜色(hex,6个16进制的数,红:绿:兰排列,比如 000000代表黑色)

-vn 不做视频记录

-bt tolerance 设置视频码率容忍度kbit/s

-maxrate bitrate设置最大视频码率容忍度

-minrate bitreate 设置最小视频码率容忍度

-bufsize size 设置码率控制缓冲区大小

-vcodec codec 强制使用codec编解码方式。 如果用copy表示原始编解码数据必须被拷贝。

-sameq 使用同样视频质量作为源(VBR)

-pass n 选择处理遍数(1或者2)。两遍编码非常有用。第一遍生成统计信息,第二遍生成精确的请求的码率

-passlogfile file 选择两遍的纪录文件名为file

//c)高级视频选项

-g gop_size 设置图像组大小

-intra 仅适用帧内编码

-qscale q 使用固定的视频量化标度(VBR)

-qmin q 最小视频量化标度(VBR)

-qmax q 最大视频量化标度(VBR)

-qdiff q 量化标度间最大偏差 (VBR)

-qblur blur 视频量化标度柔化(VBR)

-qcomp compression 视频量化标度压缩(VBR)

-rc_init_cplx complexity 一遍编码的初始复杂度

-b_qfactor factor 在p和b帧间的qp因子

-i_qfactor factor 在p和i帧间的qp因子

-b_qoffset offset 在p和b帧间的qp偏差

-i_qoffset offset 在p和i帧间的qp偏差

-rc_eq equation 设置码率控制方程 默认tex^qComp

-rc_override override 特定间隔下的速率控制重载

-me method 设置运动估计的方法 可用方法有 zero phods log x1 epzs(缺省) full

-dct_algo algo 设置dct的算法 可用的有 0 FF_DCT_AUTO 缺省的DCT 1 FF_DCT_FASTINT 2 FF_DCT_INT 3 FF_DCT_MMX 4 FF_DCT_MLIB 5 FF_DCT_ALTIVEC

-idct_algo algo 设置idct算法。可用的有 0 FF_IDCT_AUTO 缺省的IDCT 1 FF_IDCT_INT 2 FF_IDCT_SIMPLE 3 FF_IDCT_SIMPLEMMX 4 FF_IDCT_LIBMPEG2MMX 5 FF_IDCT_PS2 6 FF_IDCT_MLIB 7 FF_IDCT_ARM 8 FF_IDCT_ALTIVEC 9 FF_IDCT_SH4 10 FF_IDCT_SIMPLEARM

-er n 设置错误残留为n 1 FF_ER_CAREFULL 缺省 2 FF_ER_COMPLIANT 3 FF_ER_AGGRESSIVE 4 FF_ER_VERY_AGGRESSIVE

-ec bit_mask 设置错误掩蔽为bit_mask,该值为如下值的位掩码 1 FF_EC_GUESS_MVS (default=enabled) 2 FF_EC_DEBLOCK (default=enabled)

-bf frames 使用frames B 帧,支持mpeg1,mpeg2,mpeg4

-mbd mode 宏块决策 0 FF_MB_DECISION_SIMPLE 使用mb_cmp 1 FF_MB_DECISION_BITS 2 FF_MB_DECISION_RD

-4mv 使用4个运动矢量 仅用于mpeg4

-part 使用数据划分 仅用于mpeg4

-bug param 绕过没有被自动监测到编码器的问题

-strict strictness 跟标准的严格性

-aic 使能高级帧内编码 h263+

-umv 使能无限运动矢量 h263+

-deinterlace 不采用交织方法

-interlace 强迫交织法编码 仅对mpeg2和mpeg4有效。当你的输入是交织的并且你想要保持交织以最小图像损失的时候采用该选项。可选的方法是不交织,但是损失更大

-psnr 计算压缩帧的psnr

-vstats 输出视频编码统计到vstats_hhmmss.log

-vhook module 插入视频处理模块 module 包括了模块名和参数,用空格分开

//D)音频选项

-ab bitrate 设置音频码率

-ar freq 设置音频采样率

-ac channels 设置通道 缺省为1

-an 不使能音频纪录

-acodec codec 使用codec编解码

//E)音频/视频捕获选项

-vd device 设置视频捕获设备。比如/dev/video0

-vc channel 设置视频捕获通道 DV1394专用

-tvstd standard 设置电视标准 NTSC PAL(SECAM)

-dv1394 设置DV1394捕获

-av device 设置音频设备 比如/dev/dsp

//F)高级选项

-map file:stream 设置输入流映射

-debug 打印特定调试信息

-benchmark 为基准测试加入时间

-hex 倾倒每一个输入包

-bitexact 仅使用位精确算法 用于编解码测试

-ps size 设置包大小,以bits为单位

-re 以本地帧频读数据,主要用于模拟捕获设备

-loop 循环输入流。只工作于图像流,用于ffserver测试

相关推荐

ffmpeg 命令详解 参数 方便查看工具使用

【Android FFMPEG 开发】Android 中执行 FFMPEG 指令 ( 集成 mobile-ffmpeg 框架 | 完整代码示例 ) ...三、Kotlin 中执行 FFmpeg 命令 四、FFmpeg 命令执行结果查看 五、源码下载

详细介绍了ffmeg使用的参数命令,希望对大家有帮助

ffmpeg的编译过程详解,ffmpeg命令行工具在android 上的移植,通过ndk-build或者cmake方式在android studio2.2,ndk14(官网下载android studio2.2,然后通过studio上sdk下载ndk-bundle)构建工程项目。使用的ffmpeg...

ffmpeg编译时的命令详解 通用选项 • -L license • -h 帮助 • -fromats 显示可用的格式,编解码的,协议的... • -f fmt 强迫采用格式fmt • -I filename 输入文件 • -y 覆盖输出文件 • -t duration 设置...

FFMPEG 3.4.1 版本参数详细说明 用法:ffmpeg [options] [[infile options] -i infile] … {[outfile options] outfile} … FFMPEG获得帮助: -h – 打印基本选项 -h long – 打印更多选项 -h full – 打印所有选项...

最新 完整 FFMPEG 编译详解>> http://www.chinavideo.org/viewthread.php?tid=7837 ; <<FFmpeg在windows下的编译,搭建mingw+msys环境 [转载,有改动]>> ...

linux上视频压缩工具,直接解压就可以使用。压缩命令百度一下。ffmpeg -y -i $1 -f mp4 -vcodec libx264 -b 600000 -r 25 $2参数详解可以百度一下。

以ffmpeg为核心,包装一款局域网内接收转码并推送互联网的客户端软件。本文仅使用ffmpeg基础功能,拉流、转码、推流及简单播放设置。 工作流程 拉取远端视频流,视频流格式为 rtsp 转换为常用播放格式 rtmp 推送至...

主要介绍了java使用FFmpeg合成视频和音频并获取视频中的音频等操作,本文通过实例代码给大家介绍的非常详细,具有一定的参考借鉴价值,需要的朋友可以参考下

用Python读取视频有两种主要方法,分别是基于imageio库和OpenCV,其中OpenCV加上ffmpeg的安装编译很麻烦,推荐大家使用第一种方法,不过大家也可依据自己的需求进行使用。 方法一:使用imageio库 1. 一般imageio库...

3.7.2 MP4格式详解 53 3.8 MPEGE TS容器 61 3.9 FLV容器 62 3.10 ABS – Adaptive Bitrate Streaming 自适应串流容器 62 3.11 码率 63 3.12 流媒体的3种格式 63 3.12.1 压缩媒体文件格式 63 3.12.2 流文件格式 64 ...

ffmpeg常用命令操作:http://www.code4app.com/blog-843201-326.html #关于IJKMediaFramework/IJKMediaFramework.h找不到的问题,下载后直接拉到项目中即可 下载地址:https://pan.baidu.com/s/1boPOomN 密码::9yd...

前言 相信大家都知道nginx是...执行命令 ruby -e $(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install) 如果已经安装过,而想要卸载: ruby -e $(curl -fsSL https://raw.githubuser

一:RTMP RTMP流媒体协议是 一套 Adobe 开发的音频视频实时传输协议; 二:Nginx-rtmp nginx-rtmp 是一个基于nginx的 RTMP服务模块,开源,免费 ...三:在 ubuntu server 14 安装流程 1.先下载安装 nginx 和 nginx-rtmp ...